从2015年10月特斯拉推送第一代Autopilot系统开始,全球汽车业开始步入智驾时代。此间十年,新能源汽车的视觉方案与多传感器融合路线,将智能驾驶推向算力与数据的竞赛。

2024年4月,某国际交通监管机构发布的行业白皮书显示,L2级辅助驾驶系统在特殊工况下仍存在优化空间。

据统计数据,某抽样车企五年间记录在案的辅助驾驶相关事故中,约47%与感知系统环境识别局限相关——包括极端光环境下的误判、恶劣天气中的传感器衰减等典型案例,折射出当前技术发展的阶段性特征。

例如2016年,国外一位司机开启自动驾驶模式撞到对面一辆突然左转的拖车后死亡,因为系统误把白色拖车当成了天空,而司机当时在看电影。在明亮的天空下,自动驾驶系统没有注意到拖车的白色车身,所以没有踩刹车。

注:此案例中,以【摄像头+毫米波雷达】作为主传感器的自动驾驶方案还存在另一缺陷:拖车通常有更大的离地间隙,如果底盘太高,雷达发射的电磁波可能会直接穿过卡车底盘下的空间,而没有被卡车本身反射回来,导致“漏检”。

事实上,当前智能驾驶领域一直存在三大技术路线之争:

纯视觉方案:依赖二维图像重构三维空间,夜间误判率高;

传统激光雷达方案:点云稀疏,容易丢失关键数据;

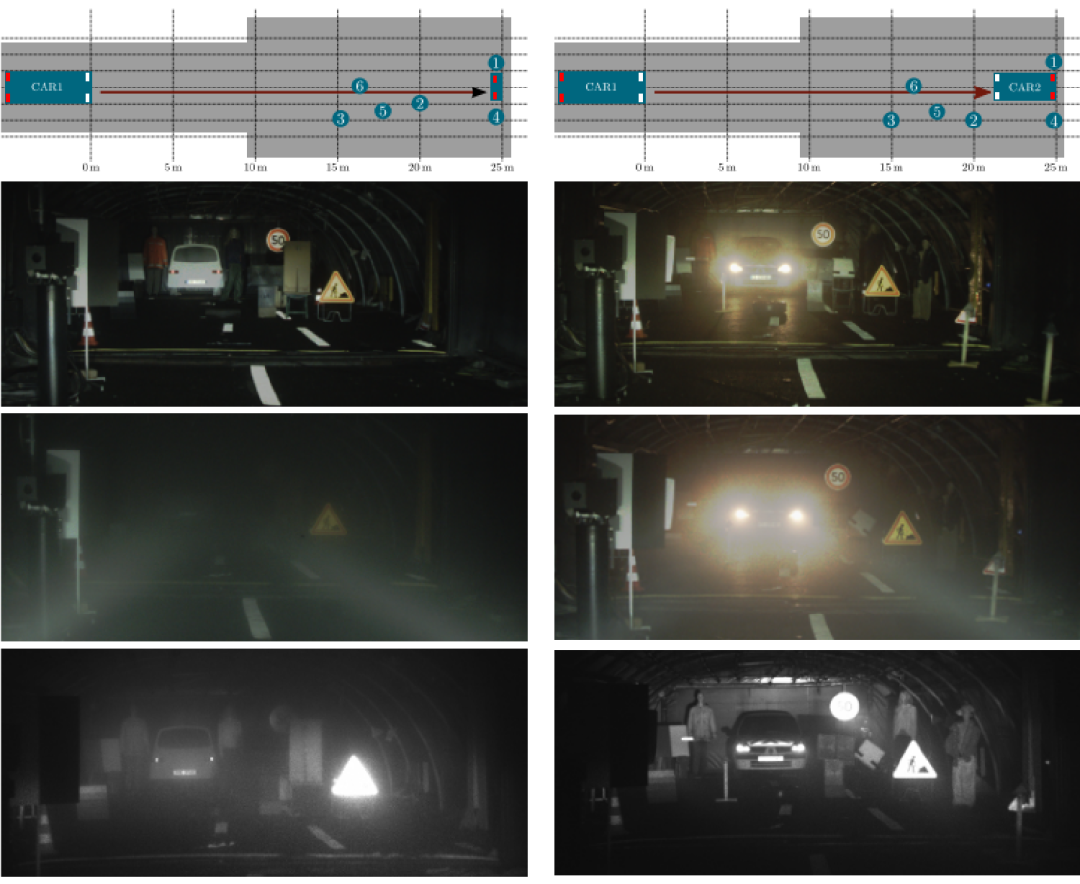

多传感器融合方案:激光雷达+视觉+毫米波雷达的冗余设计,在强光、团雾中数据冲突频发,易形成决策迟疑。

为破解智驾“盲区”,助力辅助驾驶迈入“真无人”时代,中科摇橹船选择了一条更本质的路径——重构感知的底层逻辑。

全量信息,真实3D,全天候能用,全场景识别,全场景测量,不惧强光,穿破雨雾,可将视觉、雷达感知数据合二为一。

可视化激光雷达相机摒弃了上文提到的多传感器缝合传统思路,将激光测距+光全息成像深度融合,实现两大技术突破:

物理层:通过光切片,同步捕获环境的三维结构与物质属性,让机器看见“看不见”的世界,示例:黑暗环境中可清晰识别路两侧树木及障碍物(见下图)。

算法层:以光场大模型替代了传统深度学习,将物理规律嵌入神经网络,减少对标注数据的依赖性。

实际应用效果:可视化激光雷达相机利用光原理,重建智能驾驶对物理世界的认知。

如上动图显示:搭载有该相机的汽车,夜视环境下,能防眩光,识别出“鬼探头”风险。此项技术同时跨界应用于多个场景,既是破解智能网联汽车感知难题的突破口,也成为守护长江生态水利安全的科技屏障。

港口等要地监测:穿透雨雾,视野距离最大5km,识别非法船只、漂浮物甚至水下潜航器。

低空目标的可视化观测与预警:传统视觉系统在雨雾中频繁“失明”,导致航线被迫关闭。中科摇橹船的光子灵敏度门控技术,通过动态调节激光波长与成像阈值,在大雾雨雪天气,穿云透雾,可以实现20公里高清成像,5公里厘米级检测。

应急、水利、船舶监测:支持200米水下成像。

MIT实验室最新报告指出,全球智能驾驶研发投入中,传感器硬件的占比从10%飙升至35%,重算法轻感知的时代正在终结。

智能驾驶该驶向何方?在中科摇橹船的光学实验室里给出答案,智能驾驶不仅应该有更安全的驾驶体验,更应有对技术的深沉思考。